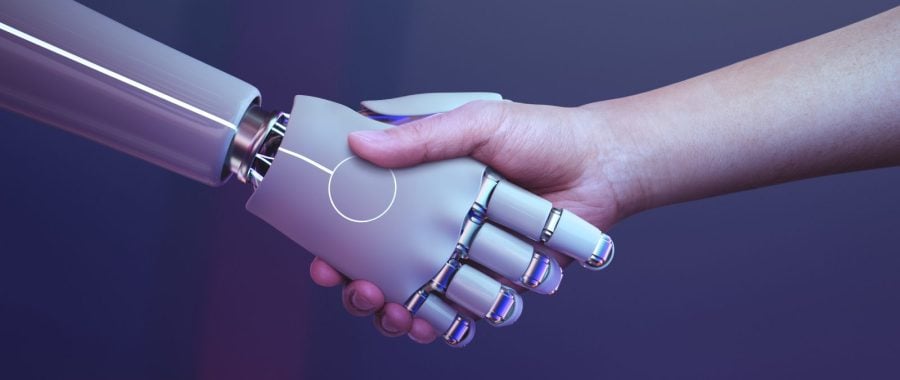

Fot. Freepik/rawpixel.com

Przez 2,5 roku doszło do rewolucji w dostępności AI

Od premiery chata GPT 2,5 roku temu doszło do rewolucji: sztuczna inteligencja stała się maksymalnie dostępna i nie istnieją bariery związane z kompetencjami użytkownika – powiedziała dr hab. Aleksandra Przegalińska z Katedry Zarządzania w Społeczeństwie Sieciowym Akademii Leona Koźmińskiego (ALK).

„Wiele osób może być zaskoczonych, ale sztuczna inteligencja rozwija się już od 80 lat” – zauważyła Aleksandra Przegalińska, prof. ALK. „Jest to dziedzina, w której powstają coraz to nowe algorytmy, które mogą się uczyć na bazie danych i udoskonalać to, co robią” – dodała.

Przypomniała, że w ramach sztucznej inteligencji istnieje wiele poddziedzin. „Są algorytmy, które zasilają robotykę; są algorytmy widzenia maszynowego, które pozwalają rozpoznawać obiekty wokół. Są algorytmy tzw. predykcyjne, które odpowiadają za dobrą prognozę pogody albo robią analitykę potencjalnie podejrzanych transakcji w banku. Ostatnio bardzo 'gorącą’ dziedziną sztucznej inteligencji jest tzw. generatywna AI – to też są algorytmy działające probabilistycznie, które są w stanie właśnie generować, coś wytwarzać. Mogą wytworzyć m.in. tekst, wizualizację, obraz, kompozycję muzyczną, wideo. One w dużej mierze są podobne do tych innych algorytmów predykcyjnych, ale mają też właściwość wytwarzania na bazie danych czegoś nowego” – powiedziała prof. Przegalińska.

>>> Prof. Jacek Kot: zdrowy organizm dobrze znosi lot w kosmos

Ekspertka podkreśliła, że to ogromna zmiana: „Nie tylko ze względu na to, że algorytmy dosyć dobrze wykonują swoje zadania – chociaż mają swoje ograniczenia; ale dlatego, że w zasadzie jest to pierwsza fala algorytmów, z którymi można spokojnie rozmawiać; których nie trzeba programować; gdzie te umiejętności techniczne (ze strony użytkownika – PAP) mogą być na sporo niższym poziomie, natomiast umiejętności, które są dla nas naturalne – konwersacje – mogą być wykorzystane w pełni. Każdy może sobie pogadać z chatem GPT czy innym modelem i coś od niego dostać”.

Profesor ALK zauważyła, że od dwóch i pół roku, czyli od momentu premiery chata GPT – nie dość, że pojawiło się dużo więcej modeli, to jeszcze doszło do rewolucji dotyczącej dostępności. „Technologia ta stała się maksymalnie dostępna; nie istnieją tu bariery związane z kompetencjami” – mówiła.

W efekcie technologia ta jest wykorzystywana na bardzo dużą skalę.

Korzystają z niej profesjonaliści, np. w tworzeniu kodu programistycznego. „Jeśli chodzi o pracę programistów, to tutaj ta zmiana jest naprawdę bardzo duża. Są zawody w obszarze programowania, które znikają na naszych oczach” – zwróciła uwagę ekspertka. „Na nieco mniejszą skalę, bo nie są tak doskonałe – modele te są wykorzystywane w innych obszarach, np. w zarządzaniu, w kreacji, w twórczości” – dodała.

Przegalińska zaznaczyła, że wielkie wyzwanie związane z AI dotyczy sektora edukacji. „Wiadomo, że studenci, ucząc się, korzystają z tych modeli. I to akurat jest OK; jest to dla nich jakiś tutor, który pomaga im się przygotować. Ale z drugiej strony (studenci) po prostu zlecają tej sztucznej inteligencji robienie rzeczy zamiast nich. I to sprawia, że ostatecznie na tym tracą, bo czegoś się nie dowiedzą, bo zrzucą na technologię jakieś zadanie do wykonania. To bardzo duże wyzwanie: jak sobie z tym poradzić? Jak weryfikować, czy ktoś naprawdę coś umie i sprawdzać jego pracę przy takiej demokratyzacji tych narzędzi?” – zastanowiła się ekspertka.

W ostatnich miesiącach coraz poważniej mówi się o problemie związanym z generowaniem za pomocą AI artykułów, które następnie publikowane są na łamach uznanych naukowych czasopism bez oznaczenia, że w procesie powstawania uczestniczyła sztuczna inteligencja.

Jak podkreśliła Przegalińska, takie działania nikomu w środowisku naukowym nie służą. „Jeśli będziemy sobie pozwalali na produkcję wiedzy, która nie jest wiedzą, a która jest halucynacją – to uderzy w nas wszystkich” – podsumowała badaczka. Zasugerowała, że ludzie nauki muszą w najbliższych latach zweryfikować, „gdzie ta technologia naprawdę daje wartość, a gdzie jest wyłącznie trampoliną do kolejnego szczebla kariery, żeby 'zaliczyć’ publikacje”. „Bo to jest bardzo słaba strategia, która nie buduje dobrej nauki” – podsumowała.

Zastrzegła, że AI warto wykorzystywać natomiast jako bardzo wartościowe narzędzie, np. w chemii, fizyce czy w badaniach społecznych: „tam jak najbardziej jest dla niej miejsce”.

„Myślę, że powoli widzimy już pewnego rodzaju korektę. Rozumiejąc, że każdy może wygenerować dzisiaj dowolny artykuł – jako środowisko naukowe odpowiadamy na to zwiększoną weryfikacją” – dodała.

Wybrane dla Ciebie

Czytałeś? Wesprzyj nas!

Działamy także dzięki Waszej pomocy. Wesprzyj działalność ewangelizacyjną naszej redakcji!

| Zobacz także |

| Wasze komentarze |

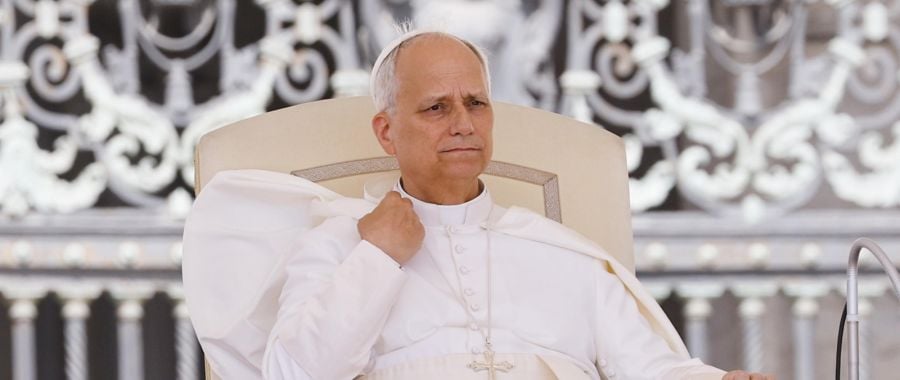

Setki wygenerowanych przez AI fałszywych kazań Leona XIV trafiło do sieci

Setki wygenerowanych przez AI fałszywych kazań Leona XIV trafiło do sieci  Ks. prof. Józef Kloch: sztuczna inteligencja może stać się wielką pomocą, nie zagrożeniem

Ks. prof. Józef Kloch: sztuczna inteligencja może stać się wielką pomocą, nie zagrożeniem  Sztuczna inteligencja pomoże w tłumaczeniu konferencji polskiej prezydencji

Sztuczna inteligencja pomoże w tłumaczeniu konferencji polskiej prezydencji

Wiadomości

Wiadomości Wideo

Wideo Modlitwy

Modlitwy Sklep

Sklep Kalendarz liturgiczny

Kalendarz liturgiczny