Fot. screen z materiału youtube Nauka. To lubię

Tomasz Rożek: AI nie jest demokratyczną technologią [ROZMOWA]

– Są już badania pokazujące, że ta technologia ma dużo większy potencjał uzależniający niż na przykład media społecznościowe – mówi Tomasz Rożek w rozmowie na temat AI (sztucznej inteligencji).

Piotr Ewertowski (misyjne.pl): Mówi się, że dzisiejsze modele AI to wciąż słaba sztuczna inteligencja, która ogranicza się jedynie do pewnych aspektów, nawet jeśli potrafi robić więcej niż jedną rzecz. Od jakiego momentu będziemy mogli mówić o tym, że mamy do czynienia z wielozadaniową, silną AI? Czy jeszcze daleko nam do tego?

Tomasz Rożek: – To jest pewna teza, ale ja nie wiem, czy ją podzielam. Myślę, że w wielu miejscach to jest już silna inteligencja, a czasem nawet silniejsza od naszej. Oczywiście wszystko leży w definicji słowa inteligencja. Jeżeli mówimy o sprawnym radzeniu sobie z informacjami, sprawnym wyszukiwaniu, sprawnym kojarzeniu – to ona jest silniejsza od naszej.

Jeżeli mówimy o uniwersalności, to tutaj mógłbym mieć pewne zastrzeżenia. Co by obecny model AI zrobił, gdyby się mu powiedziało: „Idź, zrób mi teraz kawę”? I to jest pytanie bez odpowiedzi, dlatego że my w zasadzie nie mamy jeszcze do czynienia z czymś, co u człowieka jest integrowane, czyli z umysłem i z ciałem. Jasne, są roboty, ale co się może wydawać nieintuicyjne, łatwiej jest wybudować program, który robi niesamowite rzeczy niż nauczyć robota zwykłego wchodzenia po schodach. Dlatego robotyka rozwija się dużo wolniej niż oprogramowanie.

Dlatego póki co Chat GPT kawy nie zrobi.

– Nie zrobi, dlatego że nie ma ciała, więc nie ma jak iść do kuchni, nie ma jak przeczyścić filtra i nie ma jak nasypać tej kawy. Ale jeżeli w trakcie dyskusji, na przykład na temat filozofii Schopenhauera, powiemy mu, że teraz czas na przerwę i chcielibyśmy napić się kawy, to on bardzo sprawnie cały ten proces jej parzenia opowie.

A jeżeli tak, to gdyby miał ciało, to potrafiłby to zrobić. Więc innymi słowy, mówimy, że to jeszcze nie jest w „pełni” inteligencja, ponieważ brak jej uniwersalności i wielu rzeczy nie mogłaby zrobić. Ale pytanie jest, czy nie mogłaby zrobić naprawdę, czy jedynie dlatego, że nie ma ciała, więc fizycznie jest ograniczona, bo na razie jest tylko oprogramowaniem.

Ja raczej przychylałbym się tutaj do drugiej wersji.

>>> Polacy a sztuczna inteligencja: niepewni, ale ciekawi co przyniesie przyszłość

Z drugiej strony jest tak, że jednak obecne modele AI, w tym Chat GPT, wymagają pewnych umiejętności ich używania. Zdarzają się głośne przypadki związane z tzw. halucynacjami sztucznej inteligencji, że ktoś na podstawie zmyślonych przez nią informacji stworzył przypisy do nieistniejących książek. Jak powinniśmy jej więc używać, by rzeczywiście nam służyła?

– Musimy się nauczyć jej używać – tak samo jak innego języka. Na przykład, gdy prosimy dany model językowy, żeby podał nam literaturę na określony temat, to nie mamy pewności, że podał nam prawdę. Wówczas wystarczy zadać pytanie, czy to jest prawda, poprosić o zweryfikowanie tych informacji, lub skopiować do innego modelu językowego, by to sprawdził. Można również poprosić go o podanie linków do tej literatury.

Innymi słowy, znowu przykładamy dwie różne miary do człowieka i do modelu. Wyobraźmy sobie dyskusję z człowiekiem w grupie ludzi. Na przykład zastanawiamy się nad czymś w redakcji albo w grupie inżynierów, którzy mają wybudować most. Następuje wymiana różnych poglądów i opinii. I nawet jeżeli jeden z nich się myli albo kłamie po to, żeby podtrzymać swoją wysoką pozycję, to inny członek grupy może to zweryfikować.

A w przypadku AI od jednego modelu oczekujemy, że zawsze powie prawdę. A przecież każdy z nas codziennie mówi nieprawdę wielokrotnie. Na przykład kiedy ktoś się nas pyta „jak się masz?”, zazwyczaj odpowiadamy „świetnie” albo „dobrze”. A bywa przecież różnie. Sporo osób powie „świetnie”, nawet jak jest nieświetnie. Oczywiście tu wchodzimy w warstwę kulturową – osobie, którą średnio znamy, nie opowiadamy o wszystkich swoich problemach. Nie chcę tutaj mówić o kłamstwie na poziomie filozoficznym, lecz o faktach – wiele razy w ciągu dnia w jakiś sposób rozmijamy się z prawdą.

Mamy sposoby, choć nie zawsze skuteczne, jak to wykryć u drugiej osoby. Dlatego po prostu musimy się tego nauczyć także w przypadku modeli językowych.

Skoro ludzie się mylą nawet przez przypadek albo dokonują niezbyt precyzyjnych uproszczeń, często nie mając przecież złych intencji, to nie powinniśmy oczekiwać, że inteligentna maszyna tego robić nie będzie.

– Gdy byliśmy u lekarza, a diagnoza jest niepokojąca lub wymaga dodatkowych działań, operacji czy jakiejś ryzykownej terapii, to wielu z nas bierze dokumentację medyczną i wybiera się do innego lekarza. Po co? Bo może się pomylił, może coś nadinterpretował, a może – kto wie – ma jakiś układ z firmą farmaceutyczną, w związku z tym jest szczególnie zainteresowany, żeby coś sprzedać. Możliwe też, że doświadczenie jednego lekarza podpowiada takie rozwiązanie, a drugiego lekarza odmienne. To pewien przykład.

To jest zupełnie normalne postępowanie pomiędzy ludźmi – że im ważniejszy temat, tym chętniej całkiem spora grupa z nas po prostu to weryfikuje, sprawdza w innym źródle. To dlaczego inaczej podchodzimy do AI? Gdybyśmy robili podobnie w przypadku sztucznej inteligencji i weryfikowali informacje pomiędzy różnymi modelami językowymi, to w zasadzie problem halucynacji znika.

Ciekawe, dlaczego traktujemy halucynacje AI inaczej niż w przypadku ludzkiej inteligencji.

– Wydaje nam się, że z jednej strony chcielibyśmy, czy świadomie, czy nie, żeby to coś działało tak jak człowiek. A z drugiej strony wydaje nam się, że to powinno działać lepiej niż człowiek. A równocześnie mówimy, że to jeszcze nie działa tak dobrze jak człowiek.

Co to znaczy lepiej niż człowiek? To znaczy, żeby nigdy nie kłamało, nigdy się nie myliło, nigdy nie nadinterpretowywało, zawsze wszystko wiedziało na dowolny temat, było otwarte, kompetentne, przystępne. No ale chwila, są tacy ludzie?

Skoro nie ma ludzi, którzy mieliby tak szeroką wiedzę, że na każdy temat po prostu się posługują nią z łatwością, to dlaczego – chcąc stworzyć, mówiąc skrótowo, niejako elektroniczną kopię umysłu człowieka – oczekujemy, że w pierwszym kroku wybudujemy tak idealne urządzenie? To oprogramowanie uczy się przecież na danych, które mu przedstawiamy. Jest też oparte na mechanizmach, które podpatrzyliśmy w naszym mózgu.

Czyli na sieciach neuronowych.

– Tych analogii jest więcej, my nie potrafimy zrozumieć i powiedzieć, co tam dokładnie się dzieje w tych sieciach neuronowych, że ten algorytm daje taką, a nie inną odpowiedź. Niektórych to bardzo niepokoi, bo to jest taka czarna skrzynka.

Ale z drugiej strony, mamy dokładnie taki sam problem z mózgiem człowieka. Co do zasady wiemy, jak on działa, ale nie mamy pojęcia co do szczegółu, dlaczego przypominają nam się akurat te rzeczy, dlaczego podjęliśmy taką decyzję, a nie inną itp.

A Pana niepokoi to, że nie wiemy, co tam się dzieje w tych sieciach neuronowych?

– Niespecjalnie. Raczej mnie niepokoi pogląd, że rozwój tej technologii jest wartością samą w sobie, więc skoro rozwój jest priorytetem, to powinniśmy spod nóg wycofać wszelkie przeszkody dla tego rozwoju, w tym na przykład kwestie regulacyjne. Uważam, że kwestie regulacyjne powinny być bardzo poważnie potraktowane, nawet jeśli miałoby to spowolnić tempo rozwoju tej technologii.

A czy ma Pan na myśli jakąś konkretną regulację, która byłaby naprawdę potrzebna już teraz?

– Wydaje mi się, że potrzebnych ich jest całkiem sporo. To jest kwestia oczywiście oznaczania treści, które wyszły spod ręki człowieka czy AI. To tylko jeden z wielu przykładów. Ale mówiąc o regulacjach i nauce korzystania z tej technologii, mam na myśli także rodzinę i szkołę. Są już badania pokazujące, że ta technologia ma dużo większy potencjał uzależniający niż na przykład media społecznościowe.

A gdy mówimy o uzależnieniach, to już nam to wskazuje, że główną ofiarą będą tutaj dzieci i młodzi ludzie, których mózgi są szczególnie na to wrażliwe. Dlatego jeżeli obecnie mówimy o tym, że całe pokolenie młodych ludzi zostało uzależnione od mediów społecznościowych i są tego poważne konsekwencje, to jaki wpływ będzie miała technologia AI. Co my z tym robimy? My – rodzice, szkoła, rządy. To są konkretne pytania i wierzę, że kiedyś odpowiednie regulacje się pojawią.

Mówi się, że AI to demokratyczna technologia. W niedawnym tekście dla „Gościa Niedzielnego” wyjaśniał Pan, że wcale tak nie jest.

– Jest masa danych, które pokazują, że ona wcale nie jest równie dostępna, że wcale nie daje wszystkim równego kopa w górę, równego rozwoju. To nie jest demokratyczna technologia. Ja w ogóle nie wiem, czy istnieje jakaś demokratyczna technologia.

Nawet jeżeli wszystkim damy dokładnie to samo, to będą wygrywać ci, którzy wiedzą, jak tej technologii używać, czyli ci, którzy żyją w miejscu, gdzie jest sprawny system edukacji. I chociażby z tego względu być może nie ma czegoś takiego jak demokratyczna technologia.

„Po nosie” najbardziej dostanie ta najbiedniejsza warstwa społeczeństwa, bo zostanie totalnie zmieniony układ rynku pracy.

Czy w ciągu najbliższych kilku lat możemy się spodziewać tego, że dużo ludzi będzie tracić pracę, czy to tylko teoria spiskowa?

– Ludzie tracą pracę i zyskują ją nieustannie. Każda technologia cały czas coś wprowadza, a coś innego odbiera. Kluczem jest to, żeby tak zaprojektować system edukacji – na każdym jego poziomie – żeby nie tyle uczyć konkretnego zawodu, poza nielicznymi wyjątkami, ile raczej pewnych umiejętności i mobilności niż konkretnych czynności.

Rozmawialiśmy dużo o inteligencji – tej ludzkiej i tej w modelach językowych. Istnieje test Turinga w kontekście oceny inteligencji maszyn. Zapytam się żartobliwie, czym różniłby się od testu Turinga hipotetyczny test Rożka, gdybyśmy mieli go stworzyć?

– (Śmiech) Nawet mi przez myśl nie przeszło, żeby próbować się równać czy konkurować, czy choćby myśleć o tym, że wymyślę coś lepszego niż tak mądra osoba jak Alan Turing.

Wybrane dla Ciebie

Czytałeś? Wesprzyj nas!

Działamy także dzięki Waszej pomocy. Wesprzyj działalność ewangelizacyjną naszej redakcji!

| Zobacz także |

| Wasze komentarze |

W krajach niezamożnych sztuczna inteligencja może być jedyną formą dostępu do medycyny [ROZMOWA]

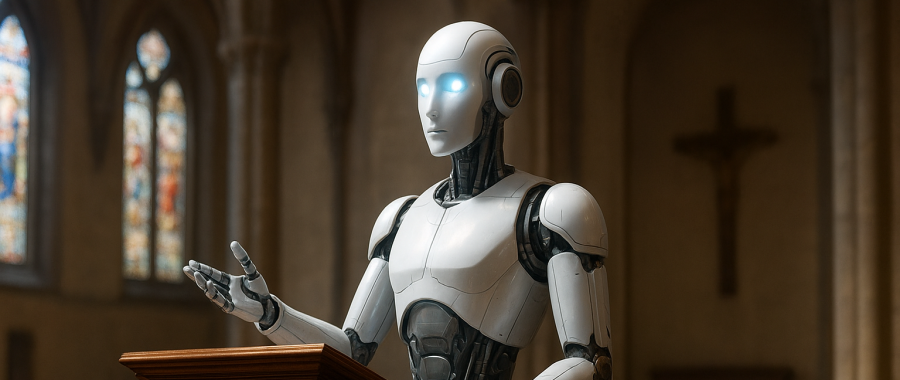

W krajach niezamożnych sztuczna inteligencja może być jedyną formą dostępu do medycyny [ROZMOWA]  Lepiej, by sztuczna inteligencja została w zakrystii, a nie „wychodziła” na ambonę [FELIETON]

Lepiej, by sztuczna inteligencja została w zakrystii, a nie „wychodziła” na ambonę [FELIETON]  Szwajcaria: sztuczna inteligencja odtworzyła ściętą w XVI wieku głowę z figury Madonny

Szwajcaria: sztuczna inteligencja odtworzyła ściętą w XVI wieku głowę z figury Madonny

Wiadomości

Wiadomości Wideo

Wideo Modlitwy

Modlitwy Sklep

Sklep Kalendarz liturgiczny

Kalendarz liturgiczny