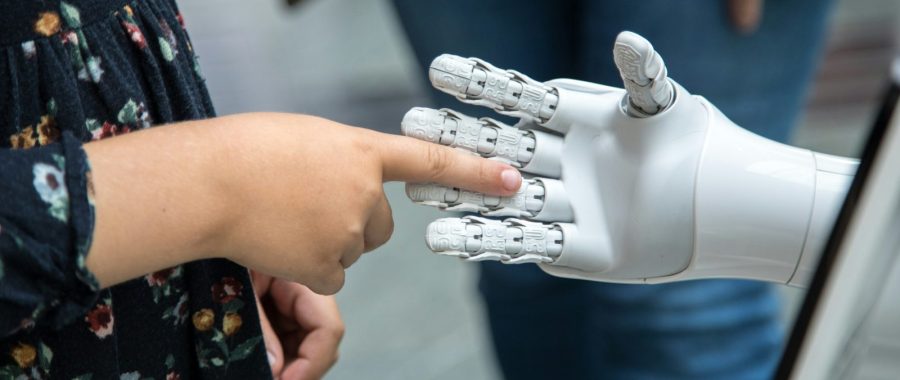

fot. katjaano/unsplash

W krajach niezamożnych sztuczna inteligencja może być jedyną formą dostępu do medycyny [ROZMOWA]

– W Europie to będzie wdrażane późno, bo mamy łatwy dostęp do lekarzy, ale w Afryce robot wykonujący zastrzyk czy analizujący zdjęcie medyczne będzie po prostu jedyną formą dostępu do medycyny – zauważa prof. Andrzej Grzybowski. W rozmowie z misyjne.pl opowiada, jak wygląda praca lekarza, gdy algorytm podpowiada coś innego niż jego własna intuicja, dlaczego halucynacje modeli to realne zagrożenie dla pacjentów i po co powinniśmy poznawać ograniczenia AI (sztucznej inteligencji).

Od 2019 roku prof. Andrzej Grzybowski (profesor nauk medycznych pracujący na Katedrze Okulistyki Uniwersytetu Warmińsko-Mazurskiego) prowadzi w Wielkopolsce pionierski program wykorzystania sztucznej inteligencji do wczesnego wykrywania retinopatii cukrzycowej. Współpracuje z piętnastoma poradniami diabetologicznymi oraz mobilnym „retinobusem”, który dociera do miejsc, w których dostęp do specjalistów jest ograniczony. Badanie jest proste: zdjęcie dna oka analizuje algorytm, a w przypadku wykrycia nieprawidłowości pacjent trafia do okulisty. Do tej pory przebadano już około 20 tysięcy osób. W rozmowie z Anną Gorzelaną prof. Andrzej Grzybowski podkreśla, że jest to dowód na to, że odpowiedzialnie wdrażana AI może realnie odciążać system ochrony zdrowia i zapobiegać utracie wzroku.

Anna Gorzelana (misyjne.pl): Kiedy słyszy pan hasło: „AI zrewolucjonizuje medycynę”, to co Pan myśli? Że to entuzjazm, marketing, czy jeszcze coś innego?

Prof. Andrzej Grzybowski: – Jestem pewien, że AI zrewolucjonizuje medycynę. Pytanie dotyczy wyłącznie tego „kiedy”, a nie „czy”. Co do tego, że to nastąpi, nie ma żadnych wątpliwości.

A w jakich obszarach sztuczna inteligencja w medycynie już dziś może ochronić życie, pomóc w jego ratowaniu?

– Musimy rozdzielić zastosowania sztucznej inteligencji na dwa obszary. Pierwszy to aplikacje praktyczne, czyli tam, gdzie AI zostało dopuszczone do użytku medycznego. Drugi to obszar badań naukowych. I trzeba powiedzieć, że ten pierwszy obszar to jest około jednego procenta – może nawet mniej – tego, co dzieje się w badaniach. Aplikacji praktycznych jest bardzo niewiele.

Dlaczego tak mało?

– Po pierwsze – stosunkowo niewiele produktów typu AI-based medical devices (czyli wyrobów medycznych opartych na AI) jest zarejestrowanych na świecie. Mam na myśli szczególnie Unię Europejską i Stany Zjednoczone, bo to są kluczowe rynki. Po drugie – spośród tych, które są zarejestrowane, w praktyce używanych jest bardzo niewiele. Problem mamy na dwóch poziomach: mało rejestracji i małe wykorzystanie nawet tego, co już dopuszczone.

Najłatwiej będzie zrozumieć to na przykładach.

– W okulistyce – i to jest zresztą pierwszy w historii autonomiczny algorytm dopuszczony do celów medycznych – w 2018 roku FDA (czyli amerykańska Agencja ds. Żywności i Leków) zarejestrowała algorytm do wykrywania retinopatii cukrzycowej. To najczęstsze powikłanie oczne u osób z cukrzycą. Retinopatia cukrzycowa to uszkodzenie siatkówki, które jest najczęstszą przyczyną utraty wzroku u osób w wieku produkcyjnym – między 18. a 65. rokiem życia – praktycznie na całym świecie. W Polsce mamy około 3 milionów ludzi z cukrzycą, a retinopatię cukrzycową ma około miliona z nich – czyli jedna trzecia. To nie jest rzadka choroba, dotycząca np. 10 tysięcy osób. To schorzenie, które dotyczy ogromnej grupy, a ryzyko rośnie wraz z czasem trwania cukrzycy.

Dlaczego tak powszechna choroba powoduje utratę wzroku? Brakuje sposobów leczenia?

– Właśnie nie. Leczenie mamy – i to bardzo skuteczne. Jeśli pacjent z retinopatią trafi do lekarza na czas, to w 95% przypadków udaje się uratować jego wzrok. Problemy są organizacyjne, nie medyczne. Pacjenci nie trafiają do lekarzy odpowiednio wcześnie. Pojawiają się dopiero wtedy, gdy zmiany są bardzo zaawansowane i kiedy leczenie nie może już być skuteczne.

Wiemy też, że narodowe programy screeningu retinopatii cukrzycowej działają. Na świecie są dwa takie programy – w Wielkiej Brytanii i w Singapurze – i przynoszą świetne efekty.

Polegają one na tym, że każdy pacjent z cukrzycą ma wykonywane badanie dna oka. Na podstawie tego badania ocenia się, czy ma retinopatię, wychwytuje się u tych pacjentów zmiany. W krajach, które te programy wprowadziły, retinopatia cukrzycowa przestała być najczęstszą przyczyną utraty widzenia – mamy dowody na to, że te programy są skuteczne.

Dlaczego więc poza Wielką Brytanią i Singapurem nie wprowadzono takich narodowych programów skrining retinopatii cukrzycowej?

– Przede wszystkim z powodu kosztów. Aktywny skrining na taką skalę jest bardzo kosztowny. Singapur jest małym krajem, do tego jednym z najbogatszych państw świata. Wielka Brytania może nie jest najbogatsza, ale ponad 20–25 lat temu uznała to za swój priorytet. Inne kraje nie chciały wydać tak dużych pieniędzy. Koszty są ogromne. Programy obejmują nie tylko diagnostykę, ale też całą logistykę.

Na czym dokładnie polegał taki screening w Wielkiej Brytanii i Singapurze?

– To dobrze ilustruje potencjalne korzyści płynące z użycia sztucznej inteligencji. Screening polegał na tym, że każdemu pacjentowi z cukrzycą wykonywano zdjęcie dna oka. Następnie te zdjęcia wysyłano do ośrodków analizy obrazów. W Wielkiej Brytanii takich ośrodków jest kilka, w Singapurze – jeden, bo to mniejszy kraj. Pracują tam specjalnie przeszkoleni technicy, którzy analizują obrazy. Przechodzą szkolenia, egzaminy, zdobywają certyfikaty i stają się ekspertami w rozpoznawaniu retinopatii cukrzycowej. Dziennie analizują setki zdjęć. Koszty tych programów to przede wszystkim koszty ludzkie: przeszkolenie, zatrudnienie, opłacanie setek techników. Do tego dochodzi logistyka: wykonywanie zdjęć, system zaproszeń, przypomnienia listowne, rejestry pacjentów zgłaszających się i niezgłaszających.

I tu wchodzi sztuczna inteligencja?

– Tak, sztuczna inteligencja rozwinęła się szczególnie w obszarach zadaniowych, takich jak rozpoznawanie wzorców, o których wiemy, że istnieją, i wiemy, jak wyglądają. Mamy obrazy, potrafimy je oceniać, więc możemy szkolić algorytmy na bazie własnej wiedzy i później sprawdzać, czy robią to dobrze. Pierwsze algorytmy dotyczące retinopatii pojawiły się dosyć szybko i wykazano, że ich skuteczność jest co najmniej tak dobra, jak skuteczność tych techników. Oznacza to ogromną szansę na obniżenie kosztów – bo eliminują np. konieczność zatrudniania techników, co daje nowe możliwości dla programów wczesnego wykrywania chorób. Jak wspomniałem, pierwszy autonomiczny algorytm dopuszczono w 2018 roku w Stanach Zjednoczonych. Dziś w Europie jest zarejestrowanych około 20 takich algorytmów. W USA mniej – FDA jest bardziej restrykcyjna – mają cztery. Tak czy inaczej, jest z czego wybierać. To nie jest tak, że nie ma urządzeń.

Co daje fakt, że algorytm jest zarejestrowany?

– To oznacza, że każda praktyka medyczna w Polsce, Francji czy w jakimkolwiek kraju UE może traktować ten algorytm jak urządzenie medyczne dopuszczone do użytku. Może go stosować. W medycynie można stosować wyłącznie certyfikowane urządzenia, więc rejestracja otwiera drogę do użycia w praktyce.

Skoro urządzenia istnieją, dlaczego wciąż się ich nie stosuje?

– Odbiorca, czyli system ochrony zdrowia, nie jest przygotowany. Rozwój technologii nie został skorelowany z edukacją środowiska medycznego. A dominujące systemy – jak NFZ czy brytyjski NHS – wprowadzają nowe rozwiązania bardzo powoli. Muszą się przekonać do skuteczności, poczekać na dalsze dowody, przetworzyć dokumentację. Ten okres „organizacyjnej bezwładności” bywa bardzo długi. AI w tym przypadku nie stanowi rewolucji medycznej. Inaczej byłoby, gdybyśmy mieli lek na raka – wtedy wszyscy natychmiast zaczynają go stosować, bo zmienia rokowania. AI w retinopatii nie poprawia samego leczenia. To nie jest medyczny przełom. To usprawnienie organizacyjne – potencjalnie ogromne, ale jednak organizacyjne. Zmienia sposób wykonywania screeningu, ale samą medycynę tylko wspiera. Aby usprawnienie działało, ludzie muszą chcieć z niego skorzystać. Lekarze, technicy, decydenci.

Czyli narzędzia istnieją, ale pytanie, na ile lekarze i system są gotowi z nich korzystać?

– Dokładnie, skoro dziś jesteśmy na poziomie około 1% praktycznych zastosowań AI w medycynie, to m.in. dlatego, że mimo gotowych narzędzi system musi chcieć za nie zapłacić. Jeśli diagnostyka oparta na AI nie będzie refundowana – nikt nie będzie jej wykonywał. Trzeba kupić algorytm, sprzęt, zapłacić za badanie. Jeśli państwo nie potraktuje diagnostyki AI na równi z innymi badaniami, to AI pozostanie ciekawostką. Nie stanie się elementem systemu.

W wielu dziedzinach opór wobec sztucznej inteligencji wynika z braku odpowiedzialności. Podobnie jest w medycynie?

– To jest osobny, bardzo poważny problem. Mamy dwa zagadnienia sztucznej inteligencji: autonomiczną i nieautonomiczną, czyli taką, która jedynie wspiera lekarza. Trzeba zauważyć, że 95% zastosowań to AI wspierająca, która pomaga lekarzowi, przyspiesza proces decyzyjny. Tam teoretycznie problem odpowiedzialności nie jest aż tak duży, bo to lekarz podejmuje ostateczną decyzję. Ale on wcale nie znika – tylko zmienia charakter. Pojawia się kwestia etyczna: co lekarz ma zrobić, gdy jego opinia różni się od opinii AI? Pojawiają się symulacje, które próbują to ustalić.

Część lekarzy może ulec sugestii AI, bo jeśli podejmą inną decyzję, a AI będzie miało rację – odpowiedzialność spadnie na nich, i to podwójnie. Ktoś powie: „AI mówiło dobrze, a ty zrobiłeś źle”. W rezultacie sytuacja lekarzy wcale nie staje się łatwiejsza. Mogą bać się samodzielności i – paradoksalnie – zacząć tylko przepisywać opinię AI, żeby czuć się bezpieczniej. A to nie byłoby dobre. Równie trudny jest scenariusz odwrotny: AI mówi „nie ma choroby”, lekarz widzi chorobę. Jeśli lekarz się pomyli – będzie oskarżony m.in. o koszty leczenia, podczas gdy AI podpowiadało dobrze. Tego typu sytuacje wymagają nowych analiz, standardów i jasnych zasad etycznych.

Powiedzmy więcej o etyce. Jakie są granice, których w Pana opinii nie wolno przekraczać, gdy używa się AI w medycynie?

Możemy oczywiście ogólnie powiedzieć, że AI nie może działać na szkodę człowieka – to fundamentalne. Natomiast określenie granic technicznych jest dużo trudniejsze. AI najpierw zacznie być intensywnie wykorzystywana nie w krajach bogatych – takich jak Unia Europejska czy Stany Zjednoczone – ale w krajach mniej zamożnych. Tam dylemat wygląda inaczej, pytanie nie brzmi: „Czy pójdę do lekarza za tydzień, czy za miesiąc?”.

– W krajach misyjnych często pytanie brzmi: „Czy w ogóle mam dostęp do lekarza?”.

– Dokładnie, w wielu regionach Afryki czy Azji nie ma lekarzy. AI może być jedyną formą dostępu do medycyny. W Polsce to jest ciekawostka. W Afryce – może to być jedyna forma diagnostyki i opieki. W Chinach, gdzie AI rozwija się bardzo dynamicznie, też widać, jak szybko te technologie są wdrażane. I kraje biedniejsze będą AI przyjmować jeszcze szybciej, bo dla nich dostęp do narzędzi sztucznej inteligencji oznacza dostęp do medycyny, na przykład rozpoznanie choroby tam, gdzie fizycznie nie ma lekarza – w Rwandzie, Kenii, Tanzanii. W tych miejscach nikt nie będzie pytał o skuteczność AI w sensie akademickim, czy to jest 80 czy 90%. Sam fakt rozpoznania choroby może komuś uratować wzrok czy życie, podobnie z wdrożeniem leczenia.

Pojawiły się już teleoperacje – widziałem ostatnio przykład kardiochirurgiczny. Chirurg, będący fizycznie we Francji, wykonywał zdalnie operację w Chinach. To oczywiście wykorzystuje wiedzę ekspertów, ale to początek. Nauczenie robota wykonywania zastrzyku to żadna filozofia. Naprawdę nie ma powodu, by szczepienia musiał robić człowiek – to kwestia czasu. W Europie to będzie wdrażane bardzo późno, bo mamy łatwy dostęp do lekarzy, ale w Afryce czy Azji robot wykonujący zastrzyk czy analizujący zdjęcie medyczne – będzie po prostu jedną z form dostępu do medycyny.

W jakim kierunku warto iść, żeby AI faktycznie służyło życiu? Na czym Pana zdaniem powinni skupić się młodzi naukowcy czy lekarze?

– Uważam, że bardzo ważne są badania naukowe nad AI. Dzięki nim lepiej rozumiemy jej ograniczenia. Jesteśmy mniej podatni na manipulacje – a jest ich tu wiele, także w świecie nauki. To ogromny przemysł, ogromne pieniądze wielkich firm. Każda forma zdobywania wiedzy o AI jest cenna, bo im więcej wiemy, tym mniej jesteśmy podatni na nadużycia i uproszczenia. Oczywiście jest też duża dyskusja o bezpieczeństwie AI – nie tylko w medycynie. I to bardzo poważna dyskusja, sam jestem daleki od bezkrytycznego podejścia. Uważam, że nie rozpoznajemy jeszcze wielu zagrożeń, ale zajmowanie się AI daje mi poczucie świadomości tych zagrożeń. To pierwszy krok do mądrego użycia tej technologii.

Jakiego typu zagrożenia ma Pan na myśli?

– Jest ich bardzo dużo – zaczynając od źle przygotowanych modeli, które generują błędne wyniki. Innym zagrożeniem mogą być tzw. halucynacje, które znamy z modeli językowych typu ChatGPT. Zachwycamy się ich funkcjami, ale przy bardziej złożonych zadaniach pojawia się mnóstwo błędów. W medycynie to nie są drobiazgi, a potencjalnie błędy zagrażające życiu.

Zagrożeniem też jest możliwość wymknięcia się AI spod kontroli. Jeśli przejdziemy od algorytmów wykonujących jeden cel do modeli rozwiązujących bardziej złożone problemy, może się okazać, że ich proces „myślowy” zacznie podążać w kierunku dla nas niekorzystnym. I choć wiem, że brzmi już to jak kino katastroficzne – ale myślę, że „Odyseja kosmiczna” nie jest niemożliwa i nie lekceważyłbym tego zagrożenia. Proponuje tez obejrzeć film Colossus: The Forbin Project (1970), który opowiada o amerykańskim systemie obrony kontrolowanym przez komputer „Colossus”, który zaczyna działać autonomicznie. Znamienny jest tam najpierw zachwyt nad możliwościami systemu, potem akceptacja braku kontroli, a następnie… poczucie bezradności. To było 55 lat temu. Nie mamy kontroli, która pozwalałaby z całą pewnością powiedzieć, że to niemożliwe.

Wybrane dla Ciebie

Czytałeś? Wesprzyj nas!

Działamy także dzięki Waszej pomocy. Wesprzyj działalność ewangelizacyjną naszej redakcji!

| Zobacz także |

| Wasze komentarze |

Lepiej, by sztuczna inteligencja została w zakrystii, a nie „wychodziła” na ambonę [FELIETON]

Lepiej, by sztuczna inteligencja została w zakrystii, a nie „wychodziła” na ambonę [FELIETON]  Ruffini: sztuczna inteligencja nie może zastąpić ludzkiej inteligencji

Ruffini: sztuczna inteligencja nie może zastąpić ludzkiej inteligencji  Szwajcaria: sztuczna inteligencja odtworzyła ściętą w XVI wieku głowę z figury Madonny

Szwajcaria: sztuczna inteligencja odtworzyła ściętą w XVI wieku głowę z figury Madonny

Wiadomości

Wiadomości Wideo

Wideo Modlitwy

Modlitwy Sklep

Sklep Kalendarz liturgiczny

Kalendarz liturgiczny